Entrevista a Diego Encinas, especialista en ciencias de datos

Por Damián Ierace, Andrea Romero y Julio Longa

“Un simulador es básicamente una herramienta para poder predecir ciertos escenarios. La idea es tener una herramienta para poder generar escenarios que en su momento eran impensados o eran muy difíciles de reproducir en la realidad. Entonces, la idea consiste en estar preparados. Por ejemplo, en un hospital para cuantificar administrativamente la cantidad de médicos, enfermeros, personal de limpieza, etc.”, describe Diego Encinas, Magister en Redes de Datos, docente e investigador de la carrera Ingeniería en Informática de la Universidad Nacional Arturo Jauretche, actualmente dirige el proyecto de investigación “Simulación, Computación de Altas Prestaciones (HPC) y optimización de aplicaciones sociales” y coordina la Diplomatura en Ciencia de Datos.

Es decir que utilizan la simulación para trabajar una situación de gestión.

Básicamente, simular es tratar de reproducir una parte de la realidad, tomar un sistema real, concentrarnos en una parte, y tratar de modelarlo matemáticamente o por software, tratar de reproducirlo para escalar, ir más allá, ver qué es lo que podría ocurrir.

Por ejemplo, un trabajo que hicimos con unos alumnos de la UNAJ que en su momento estaban muy preocupados por los horarios de los trenes, porque los utilizaban bastante, entonces ellos por su cuenta crearon un simulador para poder encontrar la mejor frecuencia de acuerdo a la cantidad de pasajeros que había por estación.

¿Eso está relacionado también con la inteligencia artificial y la Big Data? ¿De qué manera se ponen en juego y qué rol tienen estas tecnologías para lograr ese tipo de simulación?

La inteligencia artificial era una idea que ya se manejaba hace cincuenta o sesenta años y con la computación eso se pudo implementar, porque eran algoritmos demasiado grandes o muy pesados y ahí es justamente donde aparece esto de la Computación de Altas Prestaciones. Es decir, computadoras con mucho poder de cómputo, con mucho poder de procesamiento. Y eso trae aparejado el cloud computing o la nube, que básicamente son centros de supercomputación, generalmente provistos por las empresas. Para canalizar lo que les sobraba en cuanto a capacidad de almacenamiento, dijeron: “por qué no lo vendemos, por qué no se lo ofrecemos a la gente como se ofrece la energía eléctrica”. En la nube hay capacidad de procesamiento. Es como una computadora que uno podría alquilar por hora. Una computadora con mucha capacidad de procesamiento; eso es lo que se denomina cloud computing. Uno ofrece una capacidad de procesamiento al público y el público lo usa como guste.

Hablamos de capacidad de procesamiento y de grandes volúmenes de datos, pero esos datos por sí solos no tienen ningún valor, hay que ponerlos en contexto.

Hay dos temas importantes. Desde lo técnico y desde lo ético. Lo ético porque hay datos muy sensibles. Por ejemplo: qué ocurre si yo contrato una nube que tiene su centro de supercomputación en un país con el que supuestamente está todo bien, pero entra en conflicto con el nuestro y surgen leyes en época de conflicto que antes no existían. Es un aspecto complicado. Hay que tener mucho cuidado de dónde están nuestros datos. Por ejemplo, hay una ley en Estados Unidos que dice que si entran en guerra ellos pueden disponer de los datos y no tienen que pedirle permiso a nadie. ¿Nosotros estamos dispuestos a depositar nuestros datos en ese país pensando en que podría pasar eso? En cuanto a lo técnico se puede manejar cualquier tipo de datos. Obviamente hay que hacer un procesamiento, un tratamiento. En principio técnicamente se puede hacer casi todo, pero hay que tener cuidado y ciertas reglas, buenas reglas, como para que no haya un mal manejo. Como toda herramienta se puede manejar bien o mal.

¿Cuál sería entonces el objetivo de este proyecto que están llevando adelante?

Tiene que ver con el sector de salud. La idea es encontrar la mejor manera para ayudar a la gente que trabaja en el control de la propagación de enfermedades intrahospitalarias, a través de técnicas de modelado y simulación.

¿Cómo se planifican y se organizan esas técnicas?

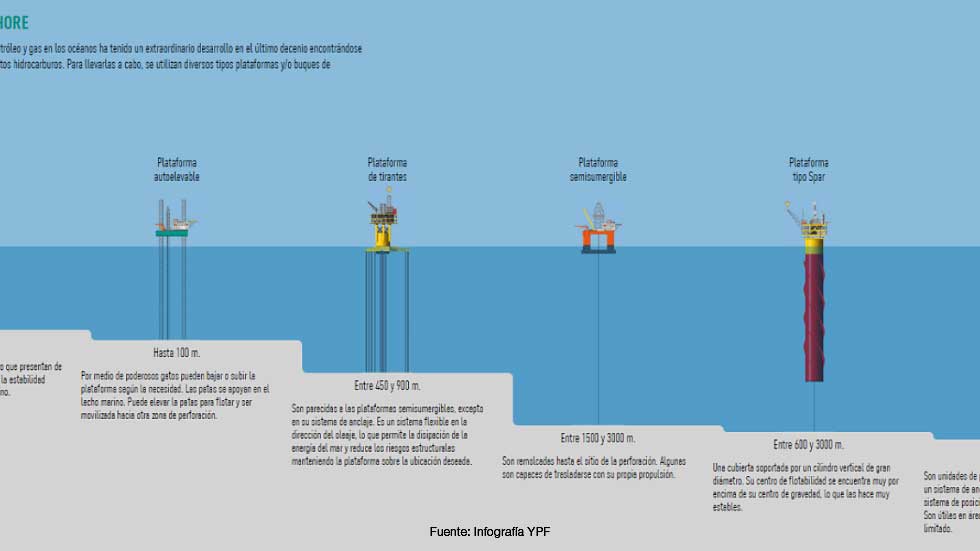

A diferencia de los centros de simulación que tenemos en la universidad y en el Hospital El Cruce, que consisten en unas especies de robots e instrumental físico donde uno puede generar un escenario: una operación, una cesárea, etc. O con el simulador de pozo de petróleo, donde hay una imagen que aparenta ser un pozo de petróleo y un instrumental que se maneja de forma similar a un simulador de vuelo, en nuestro caso es diferente. Acá lo que tenemos es lo que llamamos dashboard o tablero que va a estar en tu pantalla (en tu PC) donde se puede parametrizar o determinar las condiciones iniciales, para ver por ejemplo cuántas personas podrían llegar a aparecer para ser atendidas en una guardia a raíz de un accidente. Y evaluar cómo reacciona el sistema. Si tenemos una cantidad de médicos, una cantidad de enfermeras, personal de limpieza, administrativos, triage, etc. tenemos que hacer un modelado donde esos agentes, que son personas, están interactuando de cierta manera. Interacciones que nosotros podemos modelar de acuerdo a los datos que tenemos del sistema real. Para eso hay que tener un gran trabajo de análisis del sistema. Tenemos que analizar qué ocurre en el hospital, cuáles son sus dimensiones, cuánto personal de triage hay, cuantos enfermeros, médicos.

Volviendo al tema de los datos y la nube. ¿Hasta qué punto uno puede acceder a los datos que se encuentran en la nube? ¿Cualquier persona puede acceder a la nube? ¿Cómo funciona ese sistema? ¿Quién lo administra?

Nosotros tenemos acá docentes que han desplegado una nube interna de prueba en la UNAJ. Se puede, y hay diferentes tipos de nubes. Pero en principio lo que tenemos son servicios de cloud de distintas empresas. En cuanto al manejo de los datos, siempre hay un contrato en el que las empresas se comprometen a hacer un buen uso de esos datos, a cuidarlos, y nosotros tenemos que creerles. Lo que suelen hacer algunas instituciones que tienen datos muy sensibles, por ejemplo un hospital, es hacer nubes híbridas: contratan servicios de una empresa para que les de todas las bondades que da una empresa importante y a su vez generan un cloud privado, más chiquito, que no tiene la misma potencia que el que provee la empresa, pero que les permite guardar sus datos más sensibles como para no compartirlos.

La Diplomatura en Ciencia de Datos que dirigís trabaja muy fuertemente en estas temáticas. ¿Cuál es el abordaje que propone?

En el 2021 lanzamos la primera edición con un sesgo informático o de ingeniería, pero nos sorprendió porque tuvimos muchísimos pedidos de otras áreas: ciencias de la salud, sociales y otras. Eso nos abrió el juego para enriquecernos nosotros también. Tenemos una falencia muy grande los que somos de las ciencias exactas y nos cuesta un poco relacionarnos con otras áreas. Y ahora con estos temas que están en boga y despiertan gran interés venimos a cubrir un área que en las carreras de origen no las tienen. Datos, análisis estadístico, programación, Big Data, aprendizaje automático (machine learning). Y tratamos de explicar esos temas desde la diplomatura a un nivel inicial, como para que empiecen a caminar y a tratar con los datos.

No necesariamente uno tiene que ser especialista en informática.

No. Hay diferentes perfiles. Un analista de datos puede ser una persona que ni siquiera programa, sino que toma los datos y trata de ordenarlos de alguna forma. De hecho, hay un montón de herramientas para esto que son conocidas: del Excell a otras más importantes como por ejemplo Tablau. Entonces, con ese tipo de herramientas uno puede llegar a ordenar esos datos sin saber programar. Después están otros perfiles más técnicos, como el ingeniero de datos, que sí tiene que programar, y después está el científico de datos que ya está a otro nivel, y que tranquilamente puede ser una persona que venga del área de económicas o de sociales y que necesita tomar decisiones con esa información.

¿El desafío de la Diplomatura es presentar temas del campo de la informática, de tal manera que convenzan e interesen a gente de la disciplina, pero no sólo a ellos?

Al principio tuvimos temor porque muchos veníamos de la escuela de lo presencial y estábamos ofreciendo una carrera a distancia. La pandemia aceleró y facilitó la implementación de propuestas a distancia. En principio todo lo que es programación está en boga, es necesario, entonces mucha gente se introduce en este tema. De hecho, desde que empezó la diplomatura tenemos un sesenta por ciento de alumnos que provienen del campo de las ingenierías (no sólo informática) y un cuarenta por ciento que son médicos, economistas, sociólogos, psicólogos, etc. En ese aspecto es un desafío, pero ellos ya vienen con la cabeza lo suficientemente abierta como para recibir conceptos nuevos y también hacer el esfuerzo inicial para adquirir los conceptos necesarios, que algunos ya los tienen. Eso también enriquece el trabajo grupal.